插件安装完成后请按需设置访问限制

如需更严格限制采集,需将蜘蛛与爬虫一分钟限制改成-1(禁止访问),去除不支持识别的蜘蛛,开启真实蜘蛛"无限制"选项,开启访客与用户首次验证码与总量限制.

建议安装 "文字点击验证码" 插件,优化验证码输入体验

基础设置

受限网址:一行一个,如填写/test/ 则访问/test/前缀的网址都将由程序判断是否允许访问

不限网址:允许不受限访问的网址前缀,如后台网址 /admin/ ,验证码网址,计划任务等网址需设置成不限网址

黑名单IP:黑名单内的ip将无法访问站点,如:114.114.114.114 或114.114.114.0/24

白名单ip:白名单内的ip可无限制访问站点内容,如:127.0.0.1或192.168.0.1/24,白名单IP优于黑名单IP

访客与用户限制

首次验证码: 首次访问时是否需要填写验证码,可以有效屏蔽采集器,但用户体验不佳

访客识别:识别到采集器伪装的访客时,需要输入验证码

1/5/15分钟限制:限定时间内允许访问的次数限制,填0则不限制

总量限制:访问量超过设定的总量限制时,需先完成验证码验证方可继续访问,完成验证后,如该IP的访问量再次超过限制,则仍需重新进行验证码验证

蜘蛛限制

蜘蛛:不在名单内的蜘蛛将归类为爬虫,按"爬虫限制"设定规则

常见蜘蛛useragent: baiduspider,googlebot,bingbot,360spider,bytespider,sogou web spider,yandexbot,yisouspider

蜘蛛识别:通过IP反查与自带蜘蛛IP数据库查询是否为真实蜘蛛,伪装的蜘蛛,将按"爬虫限制"设定规则限制

当前支持反查的蜘蛛:baiduspider,googlebot,bingbot,yandexbot,yisouspider

无限制:当识别蜘蛛IP为真实蜘蛛后,不限制爬行速率,不受1,5,15分钟限制

1/5/15分钟限制:限定时间内蜘蛛允许访问的次数限制,填0则不限制,填-1则禁止访问

重试:开启后,当蜘蛛被限制速率时,将发送Retry-After响应头,告知蜘蛛应该在多久之后重试请求.

爬虫限制

黑名单:禁止的useragent关键词,一行一个,如:AhrefsBot,不区分大小写

白名单:useragent中包含白名单词的爬虫将不受爬行速率限制,未在黑白名单内的爬虫受1,5,15分钟速率限制

1/5/15分钟限制:限定时间内爬虫允许访问的次数限制,填0则不限制,填-1则禁止访问

其他限制

拒绝国内访问:禁止国内IP访问受限页面(真实蜘蛛IP除外)

拒绝国外访问:禁止国外IP访问受限页面(真实蜘蛛IP除外)

拒绝机房IP:拒绝机房IP访问受限页面(真实蜘蛛IP除外)

受限于IP库地址判断,机房IP识别不一定准确

拒绝代理访问:拒绝携带X_FORWARDED_FOR等代理特征的访问

拒绝省份访问:勾选的省份无法访问网站(真实蜘蛛IP除外)

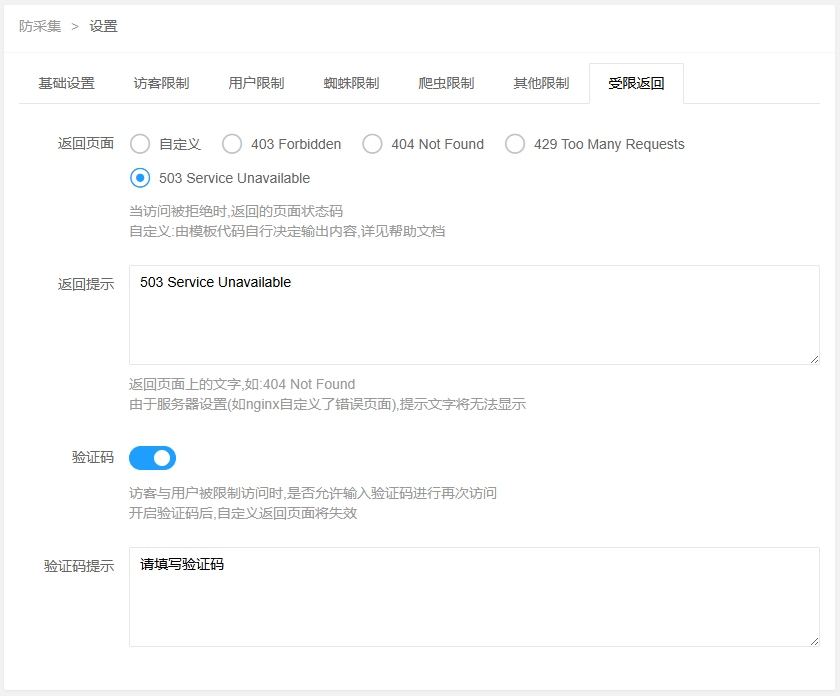

受限返回

返回页面:当访问被拒绝时,返回的页面状态码

自定义:由模板代码自行决定输出内容

//代码示例:

<?php

if(C('visitguard:limited')){

echo('已被限制');//显示已受限

}else{

echo($content);//不受限则输出文章内容

}

?>返回提示:返回页面上的文字,如:404 Not Found

由于服务器设置(如nginx自定义了错误页面),提示文字将无法显示

验证码:访客与用户被限制访问时,是否允许输入验证码进行再次访问,开启验证码后,自定义返回页面将失效